Роботов научили не подчиняться приказам человека

Команда специалистов из Университета Тафтса (США) разработала систему искусственного интеллекта, которая позволяет последнему отказываться выполнять приказы оператора, при наличии на то достаточных оснований. Новинка была недавно представлена на технологической конференции AI-HRI и уже вызвала жаркие диспуты по поводу этичности изобретения.

Проверка условий и "субординация"

Принцип работы системы выглядит так. Получив от человека приказ, машина приступает к проверке условий его выполнения. Среди них наличие необходимых навыков, физическая возможность исполнения приказа вообще, текущие обстоятельства, а также такой параметр, как "субординация", — проверка того, обязан ли робот выполнять приказы, поступившие именно от этого оператора.

Если робот обнаруживает причины, по которым приказ не может быть выполнен, он уведомляет об этом человека. Однако после уточнения исходных данных машина может "передумать" и приступить к выполнению поставленной перед ней задачи.

В качестве примера ученые записали несколько видеороликов, в которых действует робот по имени Nao. В каждом из них оператор отдает роботу устные приказы, которые тот отказывается выполнять по разным причинам. При этом в двух случаях машина все же выполняет указание после того, как оператор уточняет данные, а в третьем отказывается его выполнять "наотрез", поскольку оператор не обладает необходимыми полномочиями.

Компаньон для космонавтов

В последнее время разработчики роботов часто пытаются их "очеловечить", к примеру, научив имитировать и распознавать человеческие эмоции. Так, компанией "Нейроботикс" по заказу головного института Роскосмоса ЦНИИмаш был создан человекоподобный робот, способный не только "считывать" эмоции, но и оказывать психологическую помощь космонавтам на МКС.

"Он называется антропоморфная робототехническая система, сокращенно "Андронавт", — прокомментировал генеральный директор "Нейроботикса" Владимир Конышев. — Он понимает голосовые команды, может отвечать на них, демонстрировать изображения на вмонтированном в грудь экране. Также с помощью камер может распознавать человеческие эмоции и, соответственно, участвовать в психологической поддержке космонавта.

При этом он распознает лицо космонавта и беседует с ним на те темы, которые по результатам предыдущих бесед, были наиболее интересными для конкретного человека".

Этика и законы роботехники

Между тем некоторые исследователи в области робоэтики (этических аспектов роботехники), такие как Кейтлин Ричардсон и Эрик Бриллинг, считают, что подобные разработки противоречат общественной морали и принципам гуманизма. Так было и в случае с Nao…

Уж не приведет ли способность ослушаться человеческих приказов к пресловутому "восстанию машин" — таким вопросом задаются активисты-робоэтики. Хотя на самом деле речь идет всего лишь о "защите от дурака" — проверке перечня условий для выполнения той или иной задачи.

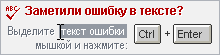

Кстати, подобные технологии уже давно применяются для разграничения доступа и в целях передачи данных в информационно-вычислительных системах. Ведь от некорректного использования машинных функций в конечном итоге окажется куда больше вреда, чем от запрета для отдельных операторов пользоваться этими функциями…

К тому же никто еще не отменял три закона роботехники, сформулированные писателем-фантастом и ученым Айзеком Азимовым в рассказе "Хоровод" (1942) и взятые на вооружение профессионалами в сфере искусственного интеллекта:

"1. Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред.

2. Робот должен повиноваться всем приказам, которые дает человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

3. Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам".

Позднее, в 1986 году, в романе "Роботы и Империя" Азимов добавил еще и Нулевой закон роботехники:

"Робот не может причинить вред человечеству или своим бездействием допустить, чтобы человечеству был причинен вред".

Таким образом, робот не способен нанести никакого "сознательного" ущерба и поставить людей в заведомо опасную ситуацию, если его никто на это не запрограммирует. Хочется надеяться, что этого никогда не случится…